来源:网络作者:server发布时间:2016-08-16点击:3507

现代企业的数据量越来越大,应用越来越多,他们开始面临当年Google遇到的问题,CIO要考虑怎么更高效的构建自己的计算和存储的基础架构,来满足应用的数据访问需求。

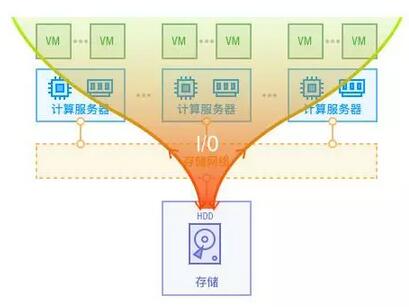

虚拟化为更容易的管理应用而生,它解决了CPU、内存资源闲置的问题。但随着虚拟化的大规模应用,虚拟机越来越多,虚拟机在传统存储上运行却越来越慢了。“慢”造成“体验差”,“体验差”成为了限制虚拟化应用的最大的瓶颈。这里面的最重要原因自然是,存储的I/O性能不够,大量的虚拟机和容器同时运行,I/O的混合,使得随机读写急剧增加,传统存储的结构无法承受大量的随机I/O。

超融合恰恰是为了解决这个问题,才被带到了虚拟化和容器领域。同时,业内也存在不同的解决I/O问题的方法,我们先尝试分析下其他的解决方法:

解决方法一:在存储设备采用SSD做Cache,加速I/O。这在一定的规模下可能有效,但是存储设备的SSD Cache通常比例较小,不足5%的容量比的情况下,自然满足不了用户的热数据的缓存需求。另外,仍然无法随需扩展,所有的数据仍然要从集中的存储控制器流出,这个集中的“收费站”势必堵塞“高速公路”。

解决方法二: 使用服务器侧SSD做Cache,加速I/O。这种类似的解决方案,通常缺乏高可靠性软件的支撑,服务器端的Cache如果用做写Cache,存在单点失效的问题,需要在多个服务器的Cache设备上,做副本来提供可靠性,可以说这是一个阉割版的超融合架构,将Cache放到服务器端,仍然使用传统存储,当Cache满,需要被写回传统存储的时候,仍然被传统存储的“控制器”限制整体性能。

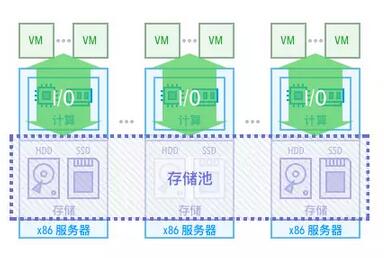

我们看到,上面的两种方案都是受限于传统存储的结构,超融合存储则不一样,通过完全去掉传统存储,利用分布式文件系统来提供“不可限量”的性能和容量,在这个基础上,再通过Cache进行加速,甚至全部使用闪存(全闪存产品)来构建都是自然而然,不被限制了。

因此,超融合架构不是为了让单台服务器的存储飞快,而是为了让每增加一台服务器,存储的性能就有线性的提升,这样的存储结构才不限制企业业务的运行,并保证业务的可靠性。

版权声明:本文系技术人员研究整理的智慧结晶,转载勿用于商业用途,并保留本文链接,侵权必究!